LM Studio 0.3.0

我们非常激动能最终分享 LM Studio 0.3.0 🥳。

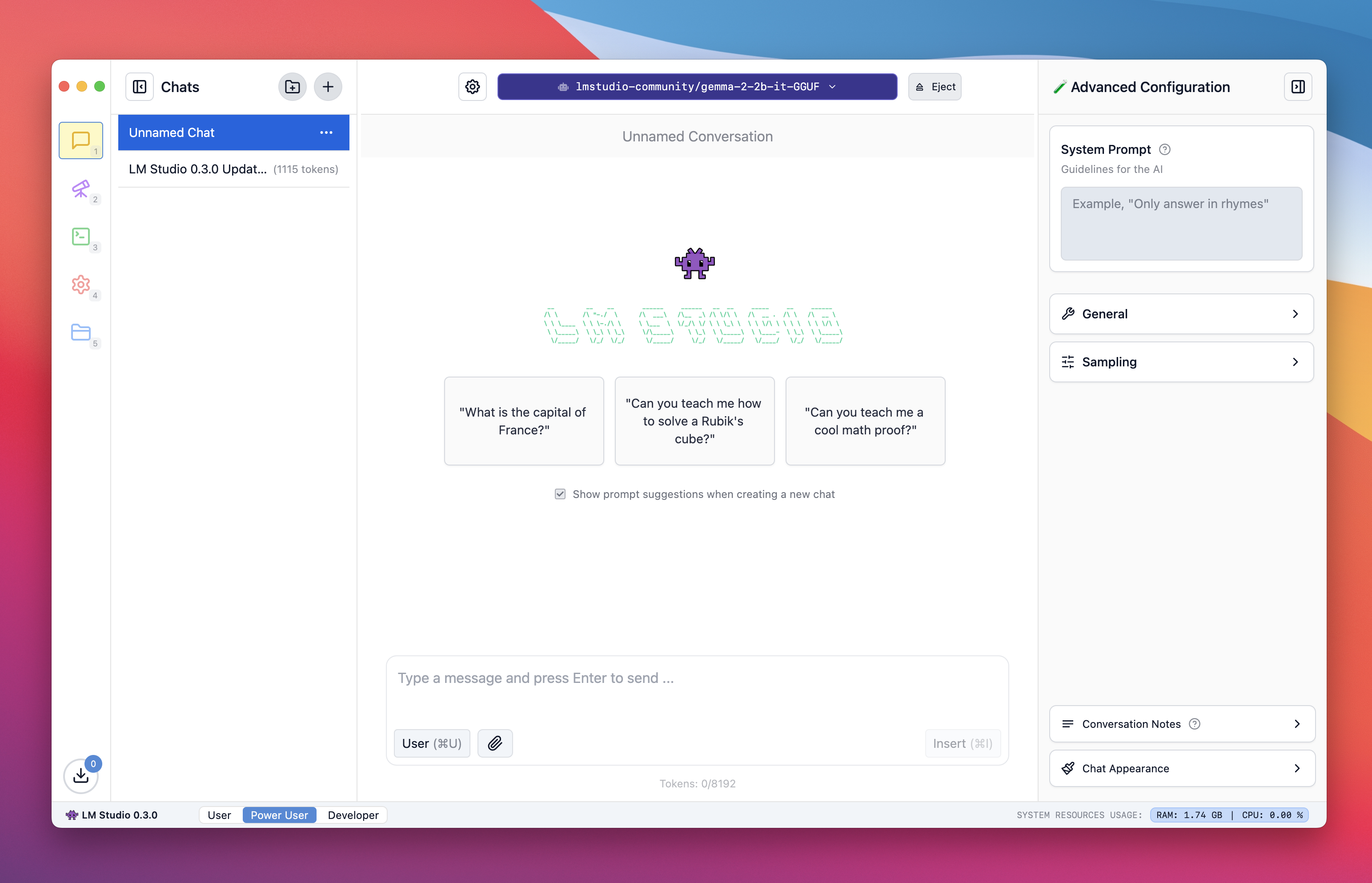

LM Studio 0.3.0 中浅色模式的新聊天页面

LM Studio

自成立以来,LM Studio 将一些元素打包在一起,以便在您的计算机上运行本地大型语言模型时充分利用它们

- 一个完全离线运行且没有遥测功能的桌面应用程序

- 一个熟悉的聊天界面

- 搜索和下载功能(通过 Hugging Face 🤗)

- 一个可以监听类似 OpenAI 端点的本地服务器

- 管理本地模型和配置的系统

通过这次更新,我们通过一年多运行本地大型语言模型所学到的经验,改进、深化和简化了其中许多方面。

从 https://lm-studio.cn 下载适用于 Mac、Windows (x86 / ARM) 或 Linux (x86) 的 LM Studio。

LM Studio 0.3.0 的新功能

与您的文档聊天

LM Studio 0.3.0 附带内置功能,可向大型语言模型提供一组文档并就这些文档提问。如果文档足够短(即,如果它适合模型的“上下文”),LM Studio 将完整地将文件内容添加到对话中。这对于支持长上下文的模型尤其有用,例如 Meta 的 Llama 3.1 和 Mistral Nemo。

如果文档非常长,LM Studio 将选择使用“检索增强生成”,通常称为“RAG”。RAG 意味着尝试从非常长的文档(或多个文档)中找出相关部分,并将其提供给模型作为参考。这种技术有时效果非常好,但有时需要一些调整和实验。

RAG 成功的秘诀:在查询中提供尽可能多的上下文。提及您期望在相关源材料中出现的术语、思想和词语。这通常会增加系统向大型语言模型提供有用上下文的机会。一如既往,实验是找到最佳方法的最佳途径。

类似 OpenAI 的结构化输出 API

OpenAI 最近发布了一个基于 JSON 模式的 API,可以生成可靠的 JSON 输出。LM Studio 0.3.0 支持在 LM Studio 中运行的任何本地模型!我们已将此功能的代码片段直接包含在应用程序中。请在“开发者”页面的右侧窗格中查找。

UI 主题

LM Studio 于 2024 年 5 月首次发布,采用深色复古主题,并适当地加入了 Comic Sans 字体。原始的深色主题一直很受欢迎,LM Studio 0.3.0 引入了 3 个额外的主题:深色、浅色、棕褐色。选择“系统”可根据您的系统深色模式设置自动在深色和浅色之间切换。

自动加载参数,但也提供完全自定义

我们中的一些人非常熟悉大型语言模型加载和推理参数的细节。但我们中的许多人,可以理解,并不在意。LM Studio 0.3.0 根据您运行的硬件自动配置所有内容。如果您想打开引擎盖并自行配置,LM Studio 0.3.0 提供了更多可自定义的选项。

专业提示:前往“我的模型”页面,查找每个模型旁边的齿轮图标。您可以设置将在应用程序中任何地方使用的每个模型的默认值。

在网络上提供服务

如果您前往服务器页面,您会看到一个名为“在网络上提供服务”的新开关。打开此功能将使服务器接受来自“localhost”之外的请求。这意味着您可以使用网络上的其他设备访问 LM Studio 服务器。结合同时加载和提供多个大型语言模型的能力,这开启了许多新的用例。

用于组织聊天的文件夹

如果您同时处理多个项目,这非常有用。您甚至可以将文件夹嵌套在文件夹中!

每个聊天的多重生成

LM Studio 已经有了一段时间的“重新生成”功能。现在,点击“重新生成”会保留之前的消息生成,您可以使用熟悉的左右箭头界面轻松地在它们之间翻页。

如何将您的聊天记录从 LM Studio 0.2.31 迁移到 0.3.0

为了支持多版本生成等功能,我们在底层引入了新的数据结构。您可以通过前往“设置”并点击“迁移聊天记录”来迁移您的 0.3.0 之前的聊天记录。这将创建一个副本,并且不会删除任何旧文件。

完整更新列表

全新 UI

- 包括主题、拼写检查和更正。

- 基于 lmstudio.js (TypeScript SDK) 构建。

- 新的聊天设置侧边栏设计。

基本 RAG(检索与生成)

- 将 PDF、.txt 文件或其他文件直接拖放到聊天窗口中。

- RAG (PDF / .docx) 的最大文件输入大小增加到 30MB。

- RAG 接受任何文件类型,但非 .pdf/.docx 文件将作为纯文本读取。

自动 GPU 检测 + 卸载

- 根据您的机器性能在 GPU 和 CPU 之间分配任务。

- 仍可手动覆盖。

浏览和下载“LM 运行时”

- 无需更新整个应用程序即可下载最新的大型语言模型引擎(例如 llama.cpp)。

- 可用选项:ROCm、仅 AVX,未来还会更多。

自动提示模板

- LM Studio 从模型文件中读取元数据并自动应用提示格式。

新的开发者模式

- 查看模型加载日志,配置多个大型语言模型以进行服务,并通过网络(不仅仅是 localhost)共享大型语言模型。

- 支持带有

json_schema的类似 OpenAI 的结构化输出。

聊天文件夹组织

- 创建文件夹以组织聊天。

提示处理进度指示器

- 显示提示处理的进度百分比。

增强的模型加载器

- 在模型加载前轻松配置加载参数(上下文、GPU 卸载)。

- 能够为给定模型文件的每个可配置参数设置默认值。

- 改进的模型加载器 UI,带有一个用于控制参数的复选框。

支持嵌入模型

- 加载和提供嵌入模型。

- 支持多个模型的并行化。

支持视觉的模型

- 聊天和 API 中的图像附件

显示对话令牌计数

- 显示当前令牌和总上下文。

提示模板自定义

- 能够覆盖提示模板。

- 编辑“Jinja”模板或手动提供前缀/后缀。

- 预设聊天模板(ChatML、Alpaca、空白等)。

对话管理

- 添加对话备注。

- 克隆和分支特定消息上的聊天。

可自定义的聊天设置

- 选择聊天样式和字体大小。

- 加载时记住每个模型的设置。

初始翻译

- 支持西班牙语、德语、俄语、土耳其语、挪威语。

- 欢迎社区贡献缺失字符串和新语言!

- https://github.com/lmstudio-ai/localization

配置参数的副标题

- 每个配置参数的描述性副标题。

更多

- 从 https://lm-studio.cn/download 下载最新的 LM Studio。

- LM Studio 新用户?请前往文档:LM Studio 入门。

- 如需讨论和社区支持,请加入我们的 Discord 服务器:https://discord.gg/aPQfnNkxGC

- 如果您想在您的组织中使用 LM Studio,请联系我们:LM Studio @ Work