LM Studio 0.3.23

📣 提示:LM Studio 现已免费用于工作!阅读更多 https://lm-studio.cn/blog/free-for-work

LM Studio 0.3.23 现已作为稳定版本发布。此版本侧重于提高可靠性、改善低配置设备的性能以及修复一些错误。

改善 openai/gpt-oss 聊天工具调用可靠性

工具名称现在在发送到模型之前会保持一致的格式。以前,名称中包含空格的工具会使 gpt-oss 感到困惑并导致工具调用失败。现在工具名称已转换为 snake_case 格式。

此外,我们修复了一些解析错误,这些错误以前可能导致聊天中出现解析错误。您可能会注意到工具调用可靠性方面的显著改进。

使用聊天补全端点从 gpt-oss 获取推理内容

这与 0.3.22 版本的行为有所不同。

message.content将不再包含推理内容或<think>标签。- 推理内容现在位于

choices.message.reasoning(非流式)和choices.delta.reasoning(流式)。 - 这与

o3-mini的行为一致。

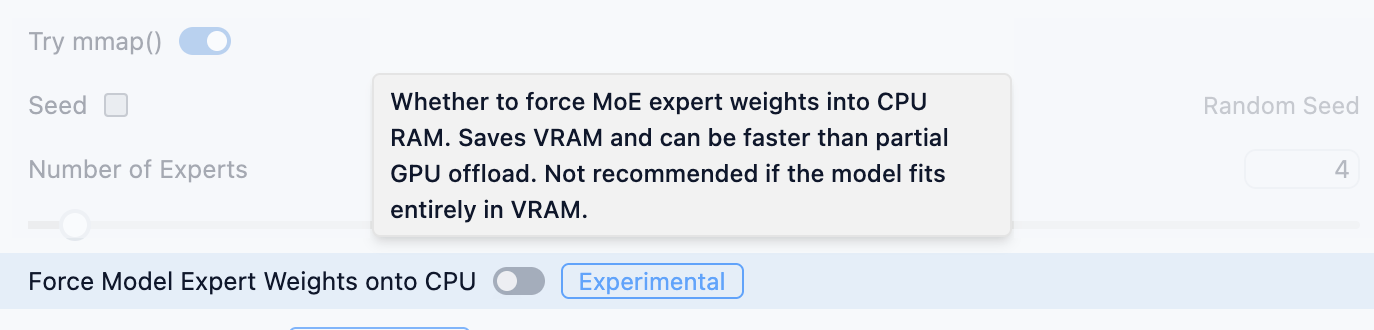

强制 MoE 专家权重到 CPU 或 GPU

在此版本中,我们添加了一个高级模型加载设置,可以将所有 MoE 专家权重放置到 CPU 或 GPU(默认)。

开启此选项可强制将 MoE 专家权重置于 CPU 上。适用于低 VRAM 的机器。

如果您没有足够的 VRAM 来将整个模型卸载到 GPU 专用内存中,这将很有用。如果是这种情况,请尝试在高级加载设置中打开“强制模型专家权重到 CPU”选项。

如果您可以将整个模型卸载到 GPU 内存中,那么最好还是将专家权重也放置到 GPU 上(这是默认选项)。

这利用了与 llama.cpp 的 --n-cpu-moe 相同的底层技术。

请记住,您可以设置持久的每模型设置。有关详细信息,请参阅文档。

LM Studio 0.3.23 - 完整发布说明

通过应用内更新或从 https://lm-studio.cn/download 升级。

版本 3

- [llama.cpp][MoE] 在高级加载设置中添加了通过“强制模型专家权重到 CPU”将专家权重卸载到 CPU/GPU RAM 的功能

- 工具名称在提供给模型之前进行规范化(替换空格、特殊字符)

版本 2

- 修复了下载精选模型时“完成下载”按钮有时不起作用的问题

- 修复了扩展包(如 Harmony)的“修复”按钮不起作用的问题

- 修复了某些包含工具的

/v1/chat/completions请求出现“Cannot read properties of undefined (reading 'properties')”错误的问题 - 修复了 Harmony 自动更新时出现

Error: EPERM: operation not permitted, unlink错误的问题

版本 1

- 错误修复,显著提高了聊天工具调用的可靠性

- 修复了应用程序中某些旧对话无法加载的错误

- 修复了在非流式模式下通过 OpenAI 兼容 API 使用工具调用有时会失败的错误

- 修复了模型在

v1/chat/completions中不输出思考标签的问题- 对于 gpt-oss

message.content将不包含推理内容或特殊标签- 这与

o3-mini的行为一致。 - 推理内容将位于

choices.message.reasoning(stream=false) 和choices.delta.reasoning(stream=true)

- 对于 gpt-oss

- 修复了在配备 AMD+NVIDIA GPU 的机器上导致应用程序功能问题的“TypeError: Invalid Version”错误

- 修复了用户模式下 MCP 插件芯片名称未渲染的错误

- 修复了单击时搜索结果刷新的错误

资源

- 下载 LM Studio:lmstudio.ai/download

- 报告错误:lmstudio-bug-tracker

- X / Twitter:@lmstudio

- Discord: LM Studio 社区