文档

API

将 LM Studio 作为服务(无头模式)运行

API

将 LM Studio 作为服务(无头模式)运行

LM Studio 的无 GUI 操作:在后台运行,在机器登录时启动,并按需加载模型。

LM Studio 可以在没有 GUI 的情况下作为服务运行。这对于在服务器上或在本地机器后台运行 LM Studio 非常有用。它适用于带有图形用户界面的 Mac、Windows 和 Linux 机器。

将 LM Studio 作为服务运行

将 LM Studio 作为服务运行包含几项新功能,旨在提高 LM Studio 作为开发工具的使用效率。

- 无需 GUI 即可运行 LM Studio 的功能

- 在机器登录时,无头模式启动 LM Studio LLM 服务器的功能

- 按需模型加载

在机器登录时运行 LLM 服务

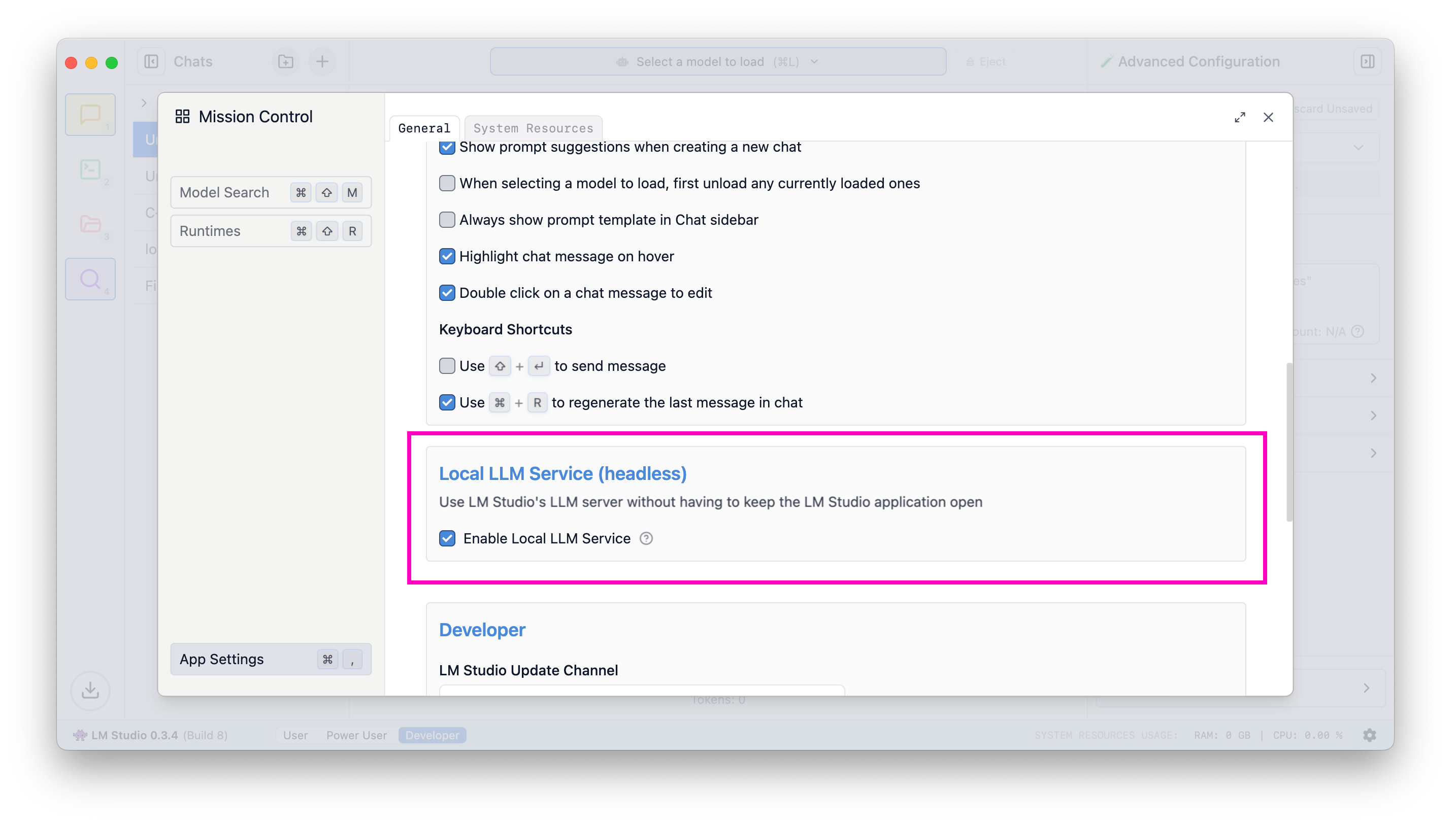

要启用此功能,请前往应用设置(Cmd / Ctrl + ,),并勾选“登录时运行 LLM 服务器”复选框。

启用 LLM 服务器在机器登录时启动

启用此设置后,退出应用程序将使其最小化到系统托盘,并且 LLM 服务器将继续在后台运行。

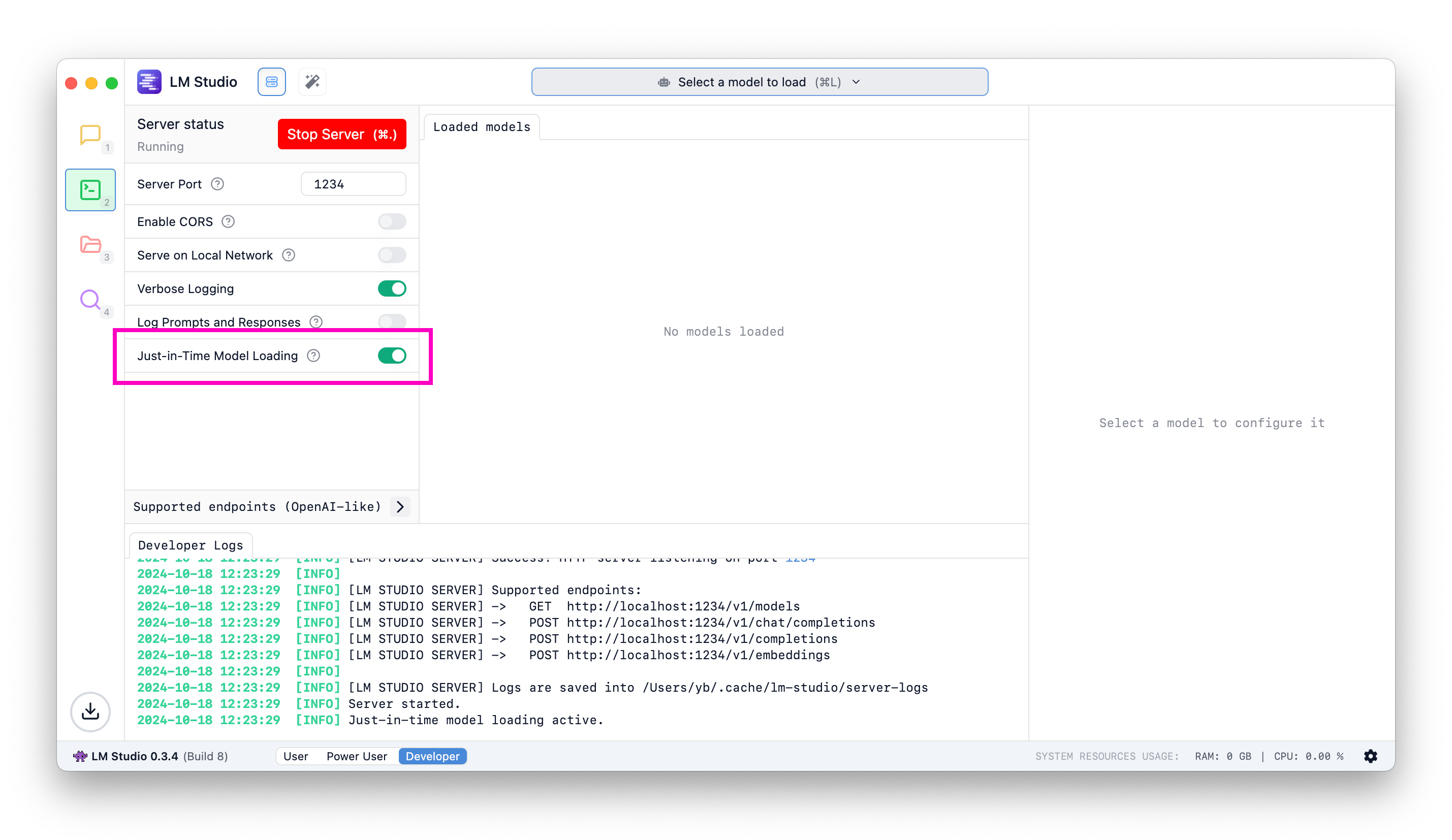

OpenAI 端点的即时 (JIT) 模型加载

当将 LM Studio 作为 LLM 服务与其他前端或应用程序一起使用时非常有用。

按需加载模型

当 JIT 加载开启时

- 调用

/v1/models将返回所有已下载模型,而不仅仅是已加载到内存中的模型 - 如果模型尚未加载到内存中,则调用推理端点将加载该模型

当 JIT 加载关闭时

- 调用

/v1/models将仅返回已加载到内存中的模型 - 您必须先将模型加载到内存中才能使用它

那自动卸载呢?

截至 LM Studio 0.3.5,自动卸载尚未到位。通过 JIT 加载的模型将保留在内存中,直到您手动卸载它们。我们预计在不久的将来实现更复杂的内存管理。如果您有任何反馈或建议,请告诉我们。

自动服务器启动

您的上次服务器状态将在应用程序或服务启动时保存并恢复。

要通过编程实现此目的,您可以使用以下命令:

lms server start

如果您尚未执行此操作,请按照此处的说明在您的机器上引导 lms。

社区

在 LM Studio Discord 服务器上与其他 LM Studio 开发者聊天,讨论 LLM、硬件等。

请在 lmstudio-bug-tracker GitHub 存储库中报告错误和问题。

本页源代码可在 GitHub 上获取

本页内容

将 LM Studio 作为服务运行

在机器登录时运行 LLM 服务

OpenAI 端点的即时 (JIT) 模型加载

- 当 JIT 加载开启时

- 当 JIT 加载关闭时

自动服务器启动

社区