文档

API

LM Studio 作为本地 LLM API 服务器

API

LM Studio 作为本地 LLM API 服务器

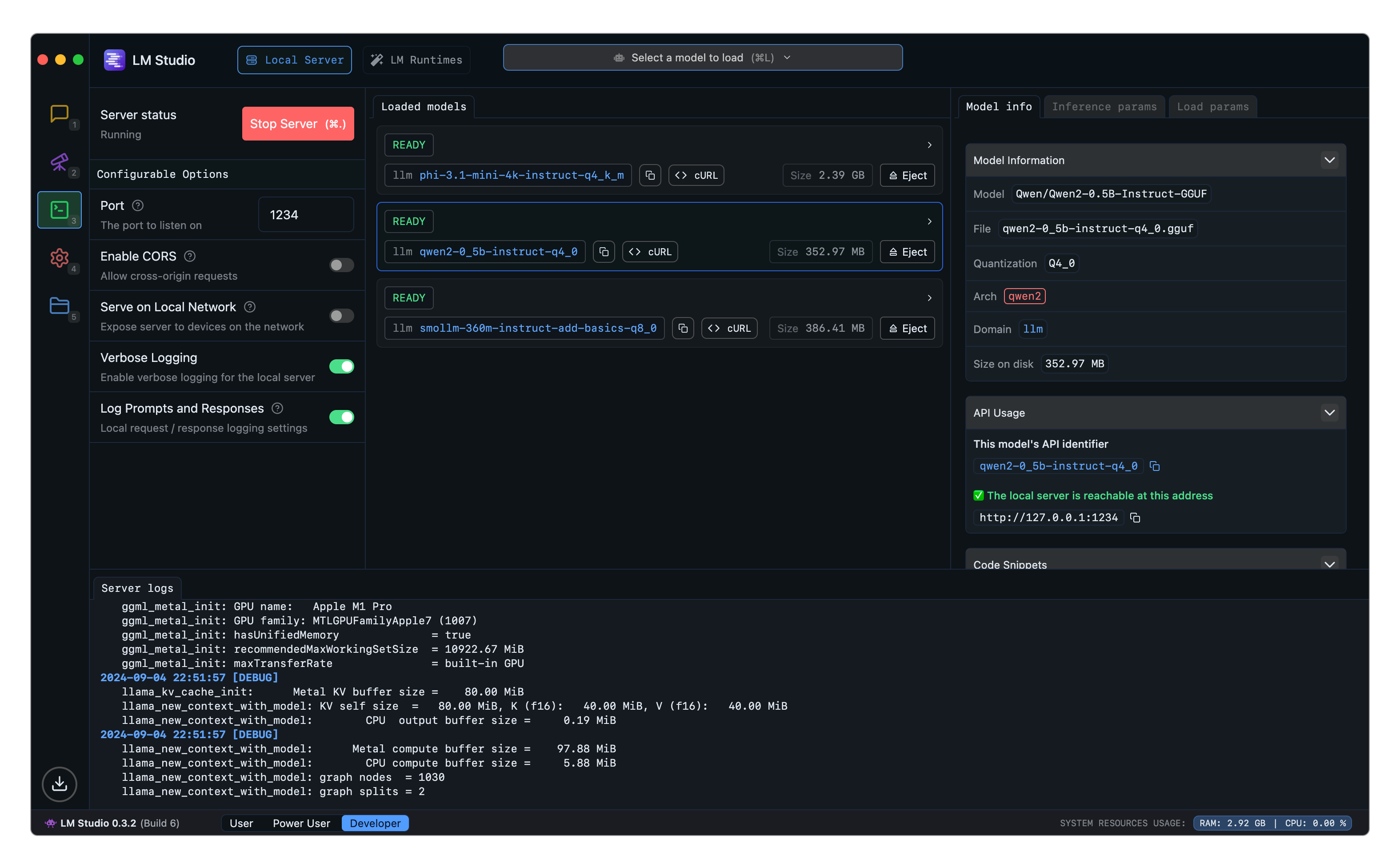

使用 LM Studio 在本地主机上运行 LLM API 服务器

您可以从 LM Studio 的开发者选项卡中提供本地 LLM,无论是在本地主机还是在网络上。

LM Studio 的 API 可以通过OpenAI 兼容模式、增强的REST API 或通过像 lmstudio-js 这样的客户端库使用。

API 选项

- TypeScript SDK -

lmstudio-js - Python SDK -

lmstudio-python - LM Studio REST API(新增,测试版)

- OpenAI 兼容端点

从 LM Studio 加载和提供 LLM

此页面的源代码可在 GitHub 上获取